Bu makalede, robots.txt dosyasının web sitelerindeki trafiği yönetmedeki temel rolünü inceleyeceğiz, varlığının gerekliliğini tartışacağız ve etkili sayfa dizinleme yönetimi için kurulumuna yönelik öneriler sunacağız. Ayrıca, robots.txt dosyasında doğru yönerge kullanımına ilişkin örnekleri analiz edeceğiz ve ayarlarının doğruluğunun nasıl kontrol edileceğine dair bir kılavuz sunacağız.

Robots.txt Neden Gereklidir?

Robots.txt, sitenin sunucusunda kök dizininde bulunan bir dosyadır. Arama motoru robotlarına kaynağın içeriğini nasıl tarayacakları konusunda bilgi verir. Bu dosyanın doğru kullanımı, istenmeyen sayfaların dizine eklenmesini önlemeye yardımcı olur, gizli verileri korur ve SEO optimizasyonunun verimliliğini ve sitenin arama sonuçlarındaki görünürlüğünü artırabilir. Robots.txt'nin yapılandırması, daha sonra inceleyeceğimiz yönergeler aracılığıyla yapılır.

Robots.txt'de Yönergeleri Ayarlama

User-Agent

Birincil yönerge User-Agent olarak bilinir, burada robotlar için özel bir anahtar sözcük belirleriz. Bu sözcüğü algıladığında, robot kuralın özellikle kendisi için tasarlandığını anlar.

Robots.txt dosyasında User-Agent kullanımına dair bir örnek ele alalım:

User-Agent: *

Disallow: /private/Bu örnek, tüm arama robotlarının (" sembolüyle gösterilir)*") konumunda bulunan sayfaları yoksaymalıdır /özel/ dizin.

İşte talimatın belirli arama robotları için nasıl göründüğü:

User-Agent: Googlebot

Disallow: /admin/

User-Agent: Bingbot

Disallow: /private/Bu durumda, Googlebot arama robotu sayfaları yoksaymalıdır /yönetici/ dizin, süre Bingbot sayfaları görmezden gelmelisiniz /özel/ dizin.

izin vermemek

izin vermemek arama robotlarına web sitesinde hangi URL'leri atlayacaklarını veya indekslemeyeceklerini söyler. Bu yönerge hassas verileri veya düşük kaliteli içerik sayfalarını arama motorları tarafından indekslenmekten gizlemek istediğinizde yararlıdır. robots.txt dosyası şu girişi içeriyorsa İzin verme: /dizinler/, o zaman robotların belirtilen dizinin içeriklerine erişimi engellenecektir. Örneğin,

User-agent: *

Disallow: /admin/Bu değer şunu gösterir: tüm robotlar ile başlayan URL'leri yok saymalısınız /yönetici/Sitenin tamamının herhangi bir robot tarafından indekslenmesini engellemek için kök dizini kural olarak ayarlayın:

User-agent: *

Disallow: /izin vermek

"İzin Ver" değeri "İzin Verme" değerinin tam tersi şekilde çalışır: robots.txt dosyasındaki diğer yönergeler erişimi yasaklasa bile, arama robotlarının belirli bir sayfaya veya dizine erişmesine izin verir.

Bir örnek düşünün:

User-agent: *

Disallow: /admin/

Allow: /admin/login.htmlBu örnekte, robotların erişime izin verilmediği belirtilmektedir. /yönetici/ dizin, hariç /yönetici/giriş.html indeksleme ve tarama için kullanılabilir sayfa.

Robots.txt ve Site Haritası

Sitemap, arama motorları tarafından dizine eklenebilen sitedeki tüm sayfaların ve dosyaların URL'lerinin bir listesini içeren bir XML dosyasıdır. Bir arama robotu robots.txt dosyasına eriştiğinde ve bir sitemap XML dosyasına bir bağlantı gördüğünde, bu dosyayı kullanarak sitedeki tüm kullanılabilir URL'leri ve kaynakları bulabilir. Yönerge şu biçimde belirtilir:

Sitemap: https://yoursite.com/filesitemap.xmlBu kural genellikle belirli bir User-Agent'a bağlı olmadan belgenin sonuna yerleştirilir ve istisnasız tüm robotlar tarafından işlenir. Site sahibi sitemap.xml kullanmıyorsa, kuralı eklemeye gerek yoktur.

Yapılandırılmış Robots.txt Örnekleri

WordPress için Robots.txt Kurulumu

Bu bölümde WordPress için hazır bir yapılandırmayı ele alacağız. Gizli verilere erişimi engellemeyi ve ana sayfalara erişime izin vermeyi inceleyeceğiz.

Hazır bir çözüm olarak aşağıdaki kodu kullanabilirsiniz:

User-agent: *

# Block access to files containing confidential data

Disallow: /cgi-bin

Disallow: /wp-admin/

Disallow: /wp-includes/

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

# Allow access to the main site pages

Allow: /wp-content/uploads/

Allow: /sitemap.xml

Allow: /feed/

Allow: /trackback/

Allow: /comments/feed/

Allow: /category/*/*

Allow: /tag/*

# Prohibit the indexing of old versions of posts and parameterized queries to avoid content duplication or suboptimal indexing.

Disallow: /*?*

Disallow: /?s=*

Disallow: /?p=*

Disallow: /?page_id=*

Disallow: /?cat=*

Disallow: /?tag=*

# Include the sitemap (location needs to be replaced with your own)

Sitemap: http://yourdomain.com/sitemap.xmlHer ne kadar tüm yönergeler yorumlarla birlikte sunulsa da, sonuçlara biraz daha derinlemesine bakalım.

- Robotlar hassas dosya ve dizinleri indekslemeyecektir.

- Aynı zamanda robotların sitenin ana sayfalarına ve kaynaklarına erişmesine izin veriliyor.

- İçerik çoğaltılmasını önlemek için eski gönderi sürümlerinin ve parametreli sorguların indekslenmesine yasak getirildi.

- Site haritasının konumu, daha iyi indeksleme için belirtilmiştir.

Böylece bazı hassas dosya ve yolların indekslemeden gizlendiği, ancak ana dizinlerin erişilebilir olduğu hazır bir yapılandırmanın genel bir örneğini ele aldık.

Birçok popüler CMS veya özel yazılmış sitenin aksine, WordPress robots.txt dosyasının oluşturulmasını ve yönetilmesini kolaylaştıran birkaç eklentiye sahiptir. Bu amaç için popüler çözümlerden biri Yoast SEO.

Kurulum için şunları yapmanız gerekir:

- WordPress yönetici paneline gidin.

- "Eklentiler" bölümünde "Yeni Ekle"yi seçin.

- "Yoast SEO" eklentisini bulun ve yükleyin.

- Eklentiyi etkinleştirin.

Robots.txt dosyasını düzenlemek için şunları yapmanız gerekir:

- Admin panelinin yan menüsünden "SEO" bölümüne gidin ve "Genel" seçeneğini seçin.

- "Araçlar" sekmesine gidin.

- "Dosyalar"a tıklayın. Burada robots.txt dahil olmak üzere çeşitli dosyalar göreceksiniz.

- İhtiyaçlarınıza göre gerekli indeksleme kurallarını girin.

- Dosyada değişiklik yaptıktan sonra "Değişiklikleri robots.txt'ye kaydet" butonuna tıklayın.

WordPress için her robots.txt dosya ayarının benzersiz olduğunu ve sitenin belirli ihtiyaçlarına ve özelliklerine bağlı olduğunu unutmayın. İstisnasız tüm kaynaklara uyacak evrensel bir şablon yoktur. Ancak bu örnek ve eklentilerin kullanımı görevi önemli ölçüde basitleştirebilir.

Robots.txt'nin Manuel Ayarlanması

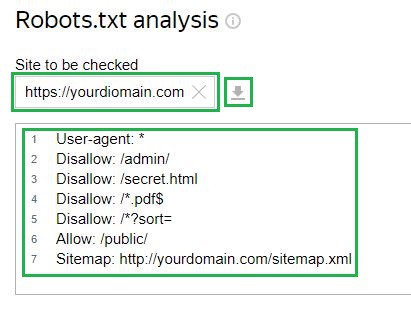

Benzer şekilde, site için hazır bir CMS olmasa bile dosyanızın yapılandırmasını ayarlayabilirsiniz. Kullanıcının ayrıca robots.txt dosyasını sitenin kök dizinine yüklemesi ve gerekli kuralları belirtmesi gerekir. İşte tüm kullanılabilir yönergelerin gösterildiği örneklerden biri:

User-agent: *

Disallow: /admin/ # Prohibit access to the administrative panel

Disallow: /secret.html # Prohibit access to a specific file

Disallow: /*.pdf$ # Prohibit indexing of certain file types

Disallow: /*?sort= # Prohibit indexing of certain URL parameters

Allow: /public/ # Allow access to public pages

Sitemap: http://yourdomain.com/sitemap.xml # Include the sitemapRobots.txt Dosyası Nasıl Kontrol Edilir

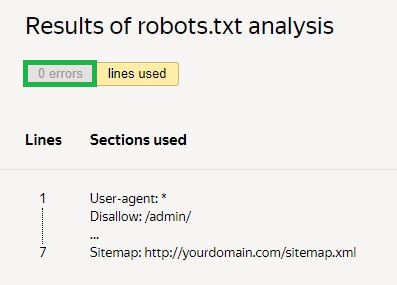

Robots.txt dosyasını hatalara karşı kontrol ederken yardımcı bir araç olarak çevrimiçi servislerin kullanılması önerilir.

Örneğin Yandex Web Yöneticisi servis. Kontrol etmek için, dosya sunucuya zaten yüklenmişse ilgili alana sitenize bir bağlantı eklemeniz gerekir. Bundan sonra, araç dosya yapılandırmasını kendisi yükleyecektir. Yapılandırmayı manuel olarak girme seçeneği de vardır:

Daha sonra bir kontrol talebinde bulunmanız ve sonuçları beklemeniz gerekiyor:

Verilen örnekte hiçbir hata yoktur. Eğer varsa, servis sorunlu alanları ve bunları düzeltmenin yollarını gösterecektir.

Sonuç

Özetle, robots.txt dosyasının sitedeki trafiği kontrol etmek için ne kadar önemli olduğunu vurguladık. Arama motorlarının sayfaları nasıl dizinleyeceğini yönetmek için düzgün bir şekilde nasıl ayarlanacağına dair tavsiyelerde bulunduk. Buna ek olarak, bu dosyanın nasıl doğru bir şekilde kullanılacağına dair örneklere baktık ve tüm ayarların doğru şekilde çalıştığını nasıl kontrol edeceğinize dair talimatlar verdik.